跟其他领域一样,在音乐制作人的圈子里,AI也成了热烈讨论的话题之一。

无数对自动化音乐的警告接踵而至,深度造假和欺诈的作品层出不穷,我们都感受到了那种被机器接管工作、艺术和生活的恐惧。我们肯定会对版权、艺术家的知识产权和道德规范有所担忧,但AI带来的并不只是完全自动化的艺术。相反,AI可以加入你现在的工作流程中,帮助你解决混音问题和创作障碍,引入之前不可能实现的创作方式。

AI究竟在做什么?

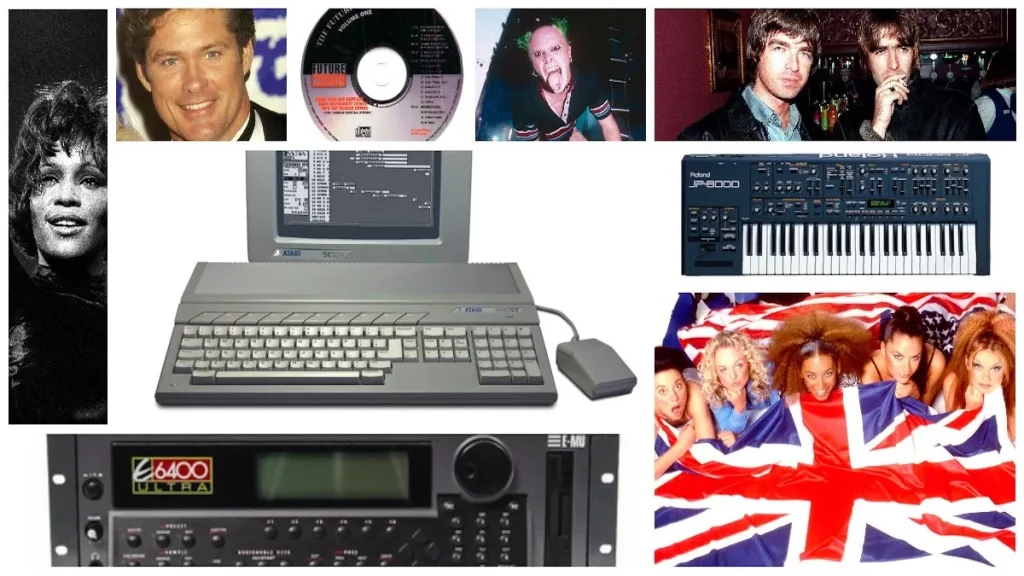

在创作过程中应用AI的方式多种多样。有人使用AI来创造声音。这可能是通过输入提示文本的方式来实现的,如Google的MusicLM就是一种生成式的AI。另外,人们会利用AI来帮助自己完成创作、混音、母带处理等繁重的工作,加快处理速度,找到完美声音,或是在创作和制作的过程里与你“协作”。这一类称为辅助AI。

虽然这两者并不是相互排斥的,因为一个工具既可以是辅助性的,也可以是生成性的,但为了符合这篇文章的用意(以及列举案例的方便),将它们分为两个类别考虑还是有帮助的。这些应用虽然看起来很简单,但根据最初训练的不同,它们的复杂程度也会有不同。AI模型是否优秀取决于它的数据库,也就是为了训练模型而输入的数据。重点要记住,一个模型,无论是辅助性还是生成性的,都不是无懈可击的,特别是在音乐创作这种需要复杂技术和主观判断搭配的应用中。

评论 (0)